OpenAI opent aanval op TikTok met AI-video app | Nieuwe Sora 2 genereert nu ook geluid en stemmen

Anthropic’s nieuwe codeer-agent, de startup met $300M voor een AI-wetenschapper en waarom RAG verdwijnt

Een AI-onderzoekslab dat ineens besluit om TikTok te trotseren. OpenAI gooit zich met hun nieuwe Sora-app volledig in de arena van social media en wil niets minder dan de manier waarop we content maken en consumeren fundamenteel veranderen.

De timing is allesbehalve toevallig. Terwijl TikTok politiek onder druk staat, zien concurrenten hun kans schoon. Maar dit gaat verder dan alleen marktpositionering. Het signaleert een verschuiving waarbij AI-bedrijven niet langer tevreden zijn met het leveren van tools, maar volledige ecosystemen willen beheersen.

In deze editie:

• Hoe OpenAI’s Sora-app de videomarkt disrupts en wat dit betekent voor je contentstrategie

• De nieuwe programmeer-agent van Anthropic die 30 uur non-stop kan coderen en projecten van A tot Z beheert

• Waarom een startup $300 miljoen ophaalt om AI-wetenschappers te bouwen die fysieke experimenten uitvoeren

• Het einde van RAG: waarom de standaardarchitectuur voor bedrijfs-AI plotting achterhaald is

OpenAI opent de aanval op TikTok

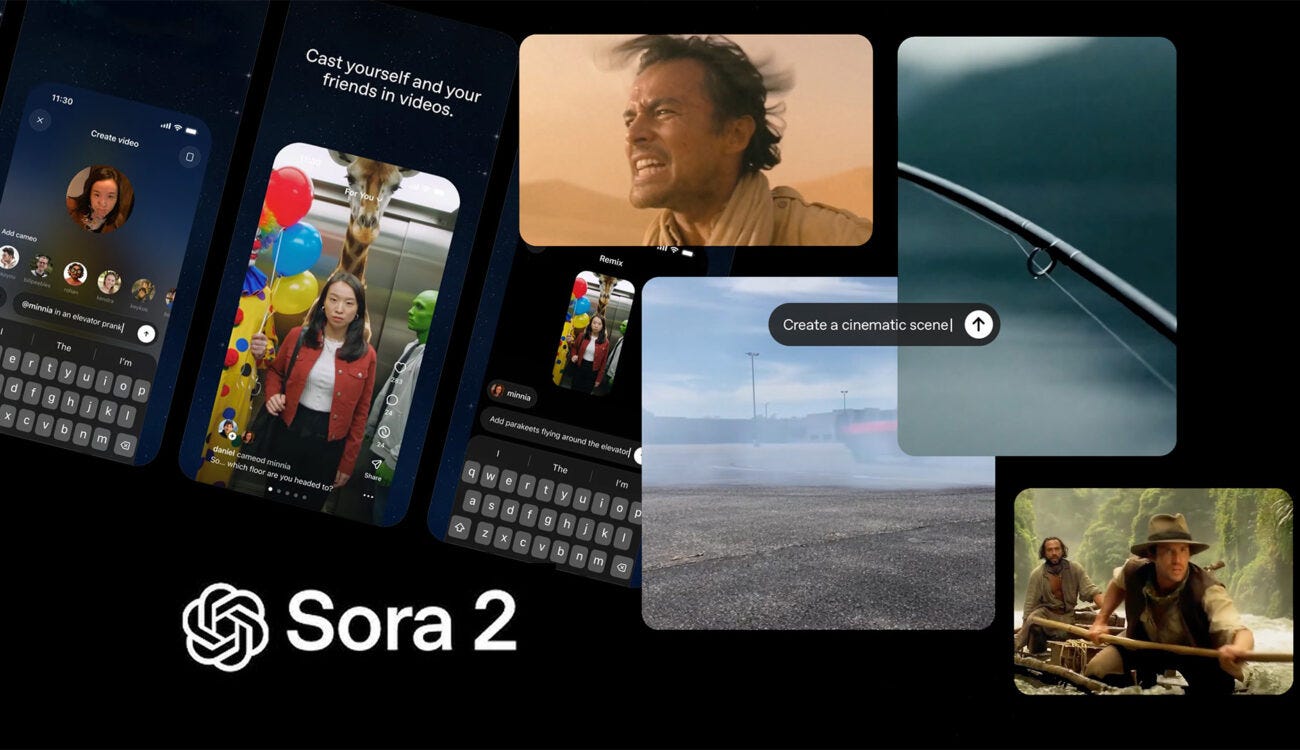

Het is officieel: OpenAI is niet langer alleen een AI-onderzoekslab. Met de lancering van de Sora-app, een directe TikTok-kloon, en een drastisch verbeterd Sora 2 videomodel, stapt het bedrijf van Sam Altman vol in de keiharde arena van social media. En de inzet is de toekomst van alle online content.

De timing is geen toeval. Terwijl TikTok politiek onder vuur ligt in de VS, ruiken concurrenten bloed. Meta lanceerde recent Vibes en Google integreert zijn Veo-model in YouTube. OpenAI gooit zich nu met volle kracht in deze strijd.

Wat Sora 2 anders maakt, is de enorme kwaliteitssprong. De beste manier om het te zien: waar de eerste Sora voelde als een experiment (GPT-1), is dit de GPT-3.5-versie. Het is het moment waarop de technologie niet alleen indrukwekkend is, maar ook praktisch bruikbaar wordt. De video’s zijn niet alleen visueel beter, het model begrijpt de wetten van de fysica en kan nu ook geluid en synchrone stemmen genereren.

De bijbehorende Sora-app is een verticale video-feed, net als TikTok, maar met één cruciaal verschil: alle content is AI-gegenereerd. De belangrijkste feature is ‘cameos’, waarmee je een geverifieerde digitale versie van jezelf in elke video kunt plaatsen. Je kunt zelfs vrienden toestemming geven om jouw digitale evenbeeld te gebruiken.

Voor ondernemers en professionals betekent dit een aantal concrete dingen:

Videoproductie wordt een fluitje van een cent. Professionele marketingvideo’s, productdemo’s of social media content die voorheen duizenden euro’s kostten, maak je straks met een simpele tekstprompt. Dit geeft met name kleinere bedrijven en zzp’ers toegang tot creatieve middelen die voorheen onbereikbaar waren.

De opkomst van synthetische personalisatie. De ‘cameo’-functie is de voorbode van een nieuwe vorm van marketing. Stel je gepersonaliseerde advertenties voor waarin jij als oprichter een klant persoonlijk aanspreekt, of waarin een klant zichzelf een product ziet gebruiken. De mogelijkheden voor engagement zijn enorm.

Een nieuwe markt voor digitale producten. De technologie zelf wordt het product. Denk aan apps die gepersonaliseerde verhalen voor kinderen genereren met henzelf in de hoofdrol, of dynamische trainingen waarin de gebruiker zichzelf de oefeningen ziet uitvoeren.

Maar er is een flinke adder onder het gras. In zijn eigen blogpost erkent Sam Altman de gevaren: verslaving, pesten en de creatie van een “RL-optimized slop feed” een eindeloze stroom door algoritmes geoptimaliseerde, inhoudsloze rommel.

Zijn vrees is al werkelijkheid. De app is nog geen dag publiek en de feed staat al vol met bizarre deepfakes van Altman zelf, waarin hij varkens in een stal vraagt: “Are my piggies enjoying their slop?”. Het platform is nu al een speeltuin voor auteursrechtschending en desinformatie.

De spanning is voelbaar binnen het bedrijf. OpenAI-onderzoekers uiten openlijk hun zorgen over het bouwen van een “oneindige AI TikTok slop-machine”. Het legt de kern van het probleem bloot: de commerciële prikkels van een social media platform, gericht op maximale schermtijd, staan haaks op de missie om AI te bouwen die de mensheid ten goede komt.

De conclusie is onvermijdelijk: de productie van professionele video wordt een commodity. De grens tussen opgenomen en gegenereerde realiteit vervaagt. Voor Nederlandse ondernemers is de uitdaging niet langer alleen het creëren van content, maar het bewaken van authenticiteit en vertrouwen in een wereld die steeds meer ‘fake’ wordt.

De AI-assistent wordt een collega: Anthropic’s nieuwe programmeur werkt 30 uur non-stop

Stel je een programmeur voor die een complexe, nieuwe softwareapplicatie bouwt. Hij werkt dertig uur aan één stuk door, zonder pauze. Hij zet databases op, koopt de domeinnaam en voert zelfs een veiligheidsaudit uit. Het klinkt onmenselijk, en dat is het ook. Dit is namelijk het werk van Anthropic‘s nieuwste AI-model.

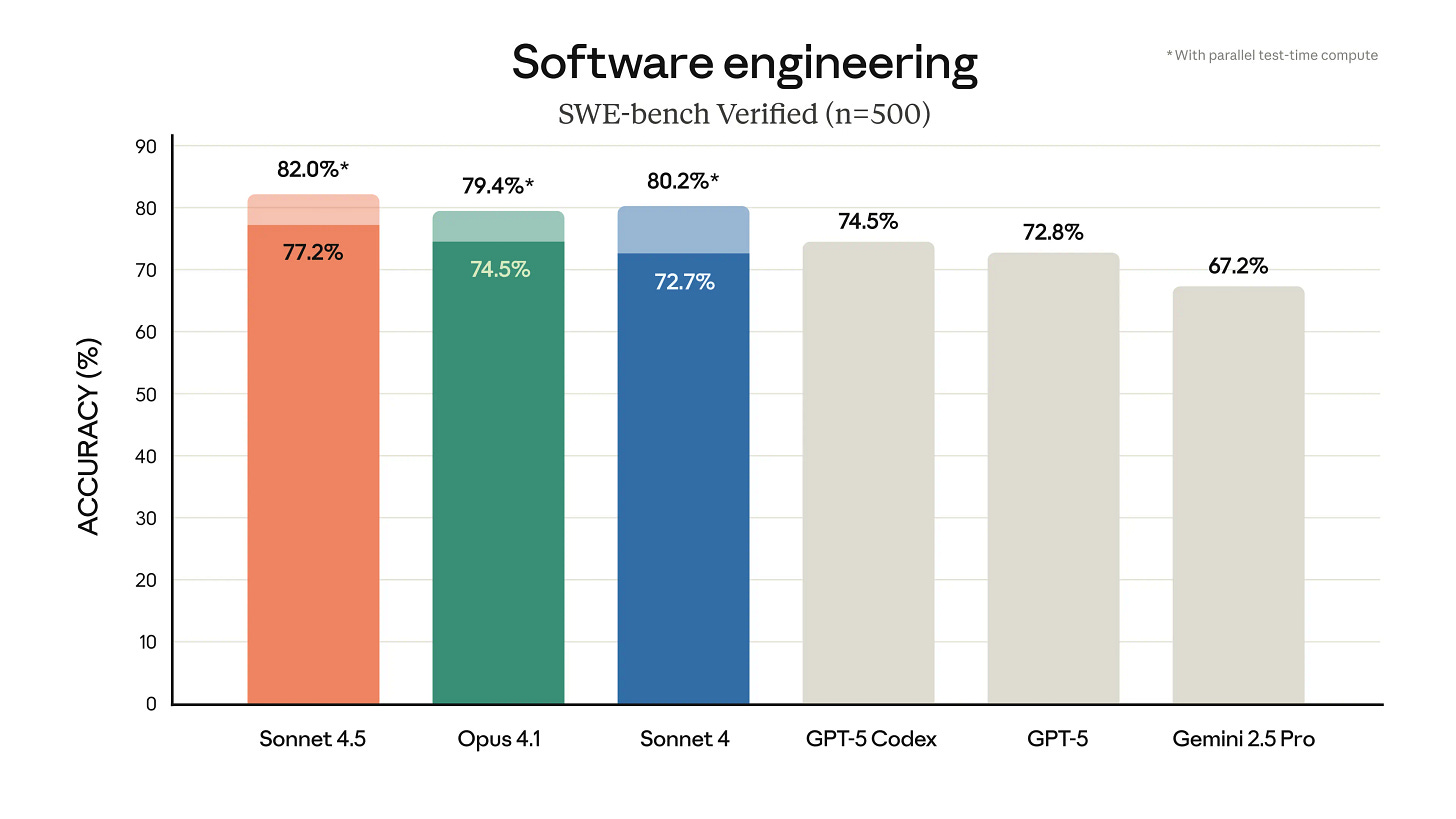

Je verzint het niet. Concurrenten als OpenAI en Google zijn nog aan het pronken met AI die slimme codefragmenten kan schrijven, maar Anthropic gooit de knuppel in het hoenderhok met Claude Sonnet 4.5. Hun claim is niet mals: het is het beste AI-model ter wereld voor het schrijven van software.

Op de belangrijke SWE-bench Verified-benchmark, die test hoe goed een AI is in het oplossen van echte softwareproblemen, scoort Sonnet 4.5 hoger dan OpenAI’s GPT-5 Codex en Google’s Gemini 2.5 Pro. Het is een indrukwekkende prestatie in de felle concurrentiestrijd die in dit domein woedt.

Maar de benchmarks zijn niet het echte verhaal. Wat hier gebeurt, is de fundamentele verschuiving van AI als assistent naar AI als autonome collega. Waar eerdere modellen na een paar uur de draad kwijtraakten, kan dit model projecten van begin tot eind beheren. Dit is een serieuze stap voorbij het genereren van een stukje Python-code. Het gaat om het orkestreren van een compleet project.

Voor Nederlandse ondernemers en professionals heeft dit concrete gevolgen:

Van prototype naar productie: De belofte is dat AI nu niet alleen meer simpele demo’s kan bouwen, maar applicaties die klaar zijn voor productie. Dit kan de ontwikkeltijd voor nieuwe producten of interne tools drastisch verkorten. Een idee voor een app kan in dagen, in plaats van maanden, een werkend product worden.

De opkomst van de AI-operator: De rol van de menselijke ontwikkelaar verandert. In plaats van zelf elke regel te typen, wordt de belangrijkste vaardigheid het aansturen, controleren en corrigeren van een AI-agent. Je wordt een manager van een digitale medewerker die het uitvoerende werk doet. Dit vraagt om andere skills: strategisch denken en extreem goede kwaliteitscontrole.

Een nieuw ecosysteem van agents: Anthropic brengt niet alleen het model uit, maar ook de Claude Agent SDK. Dit zijn de bouwblokken waarmee ontwikkelaars hun eigen gespecialiseerde AI-agenten kunnen bouwen. Denk aan een AI-agent voor financiële analyses, een voor logistieke optimalisatie, of een voor het automatiseren van marketingcampagnes. Er ontstaat een markt voor op maat gemaakte, digitale arbeidskrachten.

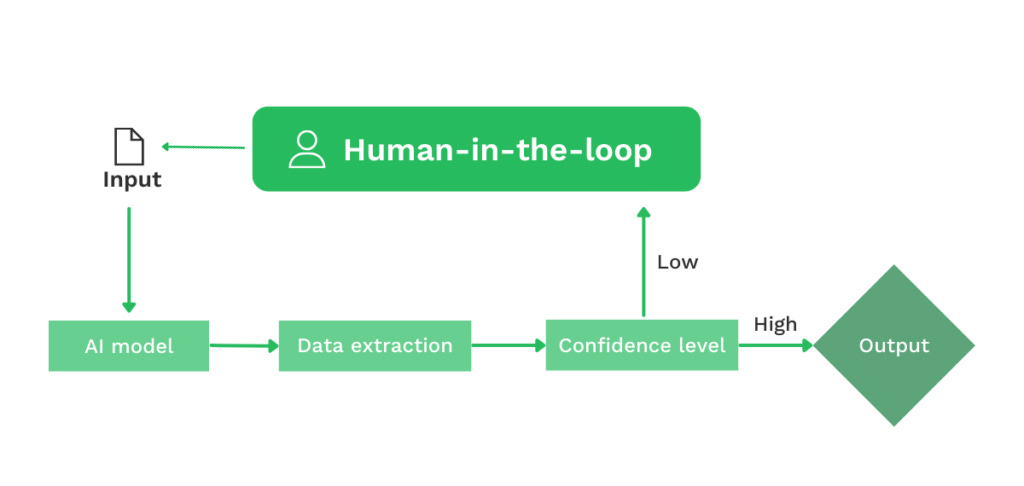

Laten we eerlijk zijn: je moet dit soort claims altijd met een korreltje zout nemen. Zoals onafhankelijke expert Simon Willison opmerkt, beweegt deze wereld zo snel dat de ‘kroon’ van het beste model binnen enkele weken weer kan worden overgedragen. Benchmarks kunnen bovendien een vertekend beeld geven van de rommelige praktijk. Wat betekent ‘productie-klaar’ écht? Wie is verantwoordelijk als de AI een subtiele maar kostbare fout in de code achterlaat die pas maanden later wordt ontdekt? De menselijke expert als eindverantwoordelijke (Human-in-the-loop) is voorlopig onmisbaar.

De kern is dat de definitie van ‘software bouwen’ aan het veranderen is. De barrière om complexe digitale producten te creëren wordt significant verlaagd. Voor Nederlandse bedrijven betekent dit dat de focus moet verschuiven van hoe je iets bouwt, naar wat je bouwt en hoe je AI-agenten effectief aanstuurt. Het is een signaal om nu te beginnen met experimenteren, voordat je concurrent dat doet.

De weddenschap van $300 miljoen op een AI-wetenschapper

Een zaaironde van $300 miljoen. Laat dat even bezinken. Dat is de duizelingwekkende som geld die Periodic Labs, een startup waar tot vorige week niemand van had gehoord, heeft opgehaald. De geldschieters zijn niet de minsten: Jeff Bezos, Eric Schmidt, Andreessen Horowitz en Nvidia staan allemaal in de rij.

De vraag is natuurlijk: waarvoor?

Het antwoord is even simpel als ambitieus: Periodic Labs bouwt geen nieuwe chatbot of beeldgenerator. Ze bouwen een AI-wetenschapper. Een systeem dat niet alleen informatie van het internet herkauwt, maar zelfstandig hypothesen opstelt, experimenten uitvoert in de fysieke wereld, en leert van de resultaten.

De oprichters, Liam Fedus (ex-OpenAI, mede-bedenker van ChatGPT) en Ekin Dogus Cubuk (ex-Google DeepMind), hebben een messcherpe observatie. De AI-modellen van vandaag hebben het internet zo goed als leeggegeten. De bron van trainingsdata, de goudmijn van de afgelopen jaren, raakt uitgeput. Om AI echt slimmer te maken, moet het de wereld in. Nieuwe kennis creëren, in plaats van bestaande kennis samenvatten.

Dat is de kern van de strategie. Periodic Labs bouwt autonome labs waar robots, aangestuurd door AI, 24/7 experimenten uitvoeren. Ze beginnen met materiaalwetenschap, op zoek naar de heilige graal: supergeleiders die werken bij kamertemperatuur. Een doorbraak die alles van computerchips tot energienetten op zijn kop zou zetten.

Dit idee komt niet uit de lucht vallen. Oprichter Ekin Dogus Cubuk leidde bij Google het team achter een vergelijkbaar, eerder succes. In 2023 ontdekte het AI-systeem GNoME meer dan 2 miljoen nieuwe kristallen, waarvan 380.000 stabiel genoeg zijn voor praktisch gebruik. Dat is de kennisequivalent van bijna 800 jaar aan menselijk onderzoek.

Wat betekent deze verschuiving voor jou als ondernemer? Een paar dingen vallen op.

Ten eerste, de waarde verschuift van data vinden naar data creëren. Jarenlang was de uitdaging om de juiste datasets te verzamelen. Nu is de echte voorsprong voor bedrijven die unieke, fysieke data kunnen genereren die niemand anders heeft. Elk experiment dat Periodic Labs uitvoert, succesvol of niet, levert een schat aan exclusieve trainingsdata op. Dit is de nieuwe concurrentievoorsprong.

Ten tweede, dit signaleert een nieuwe investeringsgolf in ‘deep tech’. De grote tech-investeerders wedden niet meer alleen op de volgende software-app, maar op bedrijven die fundamentele wetenschappelijke problemen oplossen. Dit zal ook in Europa en Nederland deuren openen voor startups die AI koppelen aan R&D in farma, energie of productie.

Tot slot is de ‘slotgracht’ niet langer het AI-model zelf, maar het fysieke lab dat de data produceert. Een superieur model is te kopiëren of te evenaren. Maar een volautomatisch laboratorium dat non-stop unieke data genereert? Dat bouw je niet zomaar na.

Natuurlijk is dit geen fluitje van een cent. Er is een reden waarom de fysieke wereld ‘moeilijk’ is. De theorie op een computerscherm is prachtig, maar de praktische realiteit van materialen die net even anders reageren, is een enorme horde. Het is één ding om 2 miljoen kristallen te voorspellen, maar het is iets heel anders om ze kosteneffectief te produceren en een commercieel levensvatbare toepassing te vinden. De brug tussen digitale simulatie en tastbaar product is waar de meeste dromen sneuvelen.

De kern van dit verhaal is de fundamentele verandering in de rol van AI. Het evolueert van een kennis-aggregator naar een kennis-generator. De focus ligt niet langer op het analyseren van wat al bestaat, maar op het ontdekken van wat mogelijk is.

Voor Nederlandse ondernemers betekent dit dat de strategische horizon verschuift. Het gaat er niet meer alleen om hoe je AI toepast op je bestaande processen en data. De echte kans ligt in het gebruiken van AI om compleet nieuwe, eigen data te creëren over je producten, materialen of markt. Daar ligt de volgende groeispurt.

Is dit het einde van RAG?

Voor veel bedrijven die serieus met AI aan de slag gaan, is Retrieval-Augmented Generation, oftewel RAG, de heilige graal. Het is de standaardarchitectuur om een taalmodel te voeden met je eigen bedrijfsdata. Teams investeren maanden en tonnen in het opzetten van complexe pipelines. En net nu iedereen erin duikt, wordt pijnlijk duidelijk: de fundamenten onder RAG brokkelen in recordtempo af.

De hele opzet van RAG was een slimme, maar noodgedwongen, workaround voor één fundamenteel probleem: de eerste generatie taalmodellen, zoals GPT-3.5, had een geheugen als een goudvis. Met een context window van slechts 4.096 tokens kon het model amper zes pagina’s tekst onthouden. Probeer dan maar eens een vraag te beantwoorden over een jaarverslag van 130 pagina’s. Het is als een financieel rapport lezen door een sleutelgat.

RAG loste dit op met een methode die rechtstreeks uit de zoekmachinewereld komt. Knip je documenten in kleine stukjes (‘chunks’), zet die stukjes om in wiskundige vectoren, en als er een vraag komt, zoek je de meest relevante stukjes op en voer je die aan het model. Simpel gezegd: het model leest niet het hele boek, maar krijgt wel de alinea’s waar de ontknoping in staat.

In theorie klinkt dit elegant. In de praktijk is het een nachtmerrie van complexiteit en foutmarges. Het opknippen van documenten vernietigt de samenhang. Een tabel wordt gescheiden van zijn kopjes, een financieel risico wordt losgerukt van de bijbehorende cijfers. Het resultaat? Onvolledige antwoorden en gevaarlijke hallucinaties.

Nicolas Bustamante, die jarenlang RAG-systemen bouwde, noemt dit het ‘cascading failure problem’. Iedere stap in de pipeline, van het ‘chunking’ tot het ‘embedden’ en ‘reranken’, introduceert nieuwe fouten. Een zoekopdracht naar ‘litigation exposure’ in een jaarverslag kan via RAG uitkomen op $500 miljoen, terwijl het werkelijke bedrag, verspreid over verschillende secties en voetnoten, $5,1 miljard is. Een factor tien verschil. Pijnlijk.

Maar nu is de centrale aanname waarop RAG is gebouwd, de ‘context-armoede’ van modellen, volledig op de schop gegaan. We betreden een tijdperk van extreme context-rijkdom.

De context windows exploderen. Claude Sonnet 4 verwerkt 200.000 tokens (ongeveer 700 pagina’s). Gemini 2.5 van Google doet 1 miljoen tokens. En Grok 4-fast zit naar verluidt al op 2 miljoen tokens. Dat is genoeg om een heel jaar aan financiële verslaglegging van een bedrijf in één keer te analyseren. Het sleutelgat is een panoramavenster geworden.

Dit opent de deur voor een fundamenteel andere, en veel robuustere, aanpak: agentic search. In plaats van documenten in stukjes te hakken, geven we een AI-agent direct toegang tot de volledige bestanden en een set simpele tools om ze te doorzoeken. Het beste voorbeeld is Anthropic’s Claude Code, een codeer-assistent. In plaats van een complexe RAG-pipeline gebruikt het een van de oudste en snelste tools die er is: grep, een command-line tool uit 1973. De agent zoekt direct in de bestanden, volgt verwijzingen en bouwt zo zelf een compleet beeld op. Het navigeert door informatie, in plaats van te zoeken naar fragmenten.

Voor ondernemers betekent dit een aantal concrete verschuivingen:

Minder kosten en complexiteit. De noodzaak voor dure en onderhoudsintensieve infrastructuur zoals Elasticsearch clusters en vector databases neemt af. Een directe, tool-gebaseerde aanpak is simpeler, sneller en goedkoper in beheer.

Hogere precisie en betrouwbaarheid. Door modellen toegang te geven tot de volledige, onversneden context, elimineer je de fouten die ontstaan door fragmentatie. De AI kan verbanden leggen, verwijzingen volgen (’zie voetnoot 12’) en de volledige samenhang begrijpen. Dit leidt tot drastisch betere en betrouwbaardere antwoorden.

Focus verlegt van ‘retrieval’ naar ‘reasoning’. De strategische focus moet niet langer liggen op het bouwen van de perfecte zoek-pipeline, maar op het ontwerpen van slimme agenten die kunnen redeneren en navigeren over een grote hoeveelheid gestructureerde data. Het gaat niet meer om de beste zoekmachine, maar om de slimste onderzoeker.

Natuurlijk is dit niet zonder haken en ogen. Bedrijven die zwaar hebben geïnvesteerd in RAG-systemen zien die investering mogelijk sneller dan verwacht verdampen. Bovendien, voor écht gigantische databases van miljoenen documenten zal een vorm van ‘search’ nog steeds nodig zijn. Alleen wordt het gedegradeerd van de kernarchitectuur tot simpelweg één van de vele tools die een agent tot zijn beschikking heeft.

Deze verschuiving is een symptoom van een nog grotere trend. We hebben de mogelijkheden van data van het internet zo’n beetje uitgeput. De volgende stap is AI die niet alleen onze data leest, maar zelf nieuwe data genereert. Zoals de startup Periodic Labs, uit het artikel hierboven, die een robotgestuurde laboratoria aan het bouwen zijn. Het doel: nieuwe materialen uitvinden, zoals supergeleiders.

Dit is geen toekomstmuziek. Google DeepMind’s GNoME-project bewees dit al door 2,2 miljoen nieuwe kristalstructuren te ontdekken, een prestatie die gelijkstaat aan 800 jaar menselijk onderzoek. De AI genereert hypothesen en de robots voeren de experimenten uit.

De kern is helder: RAG was een handige, maar tijdelijke, set zijwieltjes voor AI. Nu de modellen volwassen worden, kunnen die zijwieltjes eraf. De toekomst is niet het eindeloos perfectioneren van zoekalgoritmes, maar het bouwen van AI-agenten die met volledige context kunnen redeneren en navigeren. Voor Nederlandse ondernemers is dit het signaal om investeringen in complexe RAG-pipelines kritisch te evalueren en de focus te verleggen naar het structureren van data voor directe toegang en het ontwerpen van agentic workflows.

The Shortlist

OpenAI introduceert ‘Instant Checkout’ in ChatGPT, waarmee gebruikers in de VS direct producten van Etsy en Shopify-winkels kunnen kopen zonder de chat te verlaten en zo direct de aanval opent op de e-commerce dominantie van Google en Amazon.

Microsoft bundelt zijn Copilot Pro AI-assistent en Office-apps in een nieuw Microsoft 365 Premium-abonnement voor $19,99 per maand, een directe concurrent voor ChatGPT Plus die geavanceerde AI-tools toegankelijker maakt voor professionals.

Randstad meldt dat het aantal startersvacatures sinds begin 2024 wereldwijd met 29% is gedaald door de inzet van AI, wat de noodzaak voor jonge professionals onderstreept om zich te specialiseren in technologische vaardigheden en bedrijven dwingt hun wervingsstrategie te herzien.

Character.AI verwijdert door gebruikers gemaakte chatbots van Disney-personages van zijn platform na een sommatie van Disney, wat het aanzienlijke juridische risico van auteursrechtenschending voor bedrijven die met generatieve AI werken benadrukt.